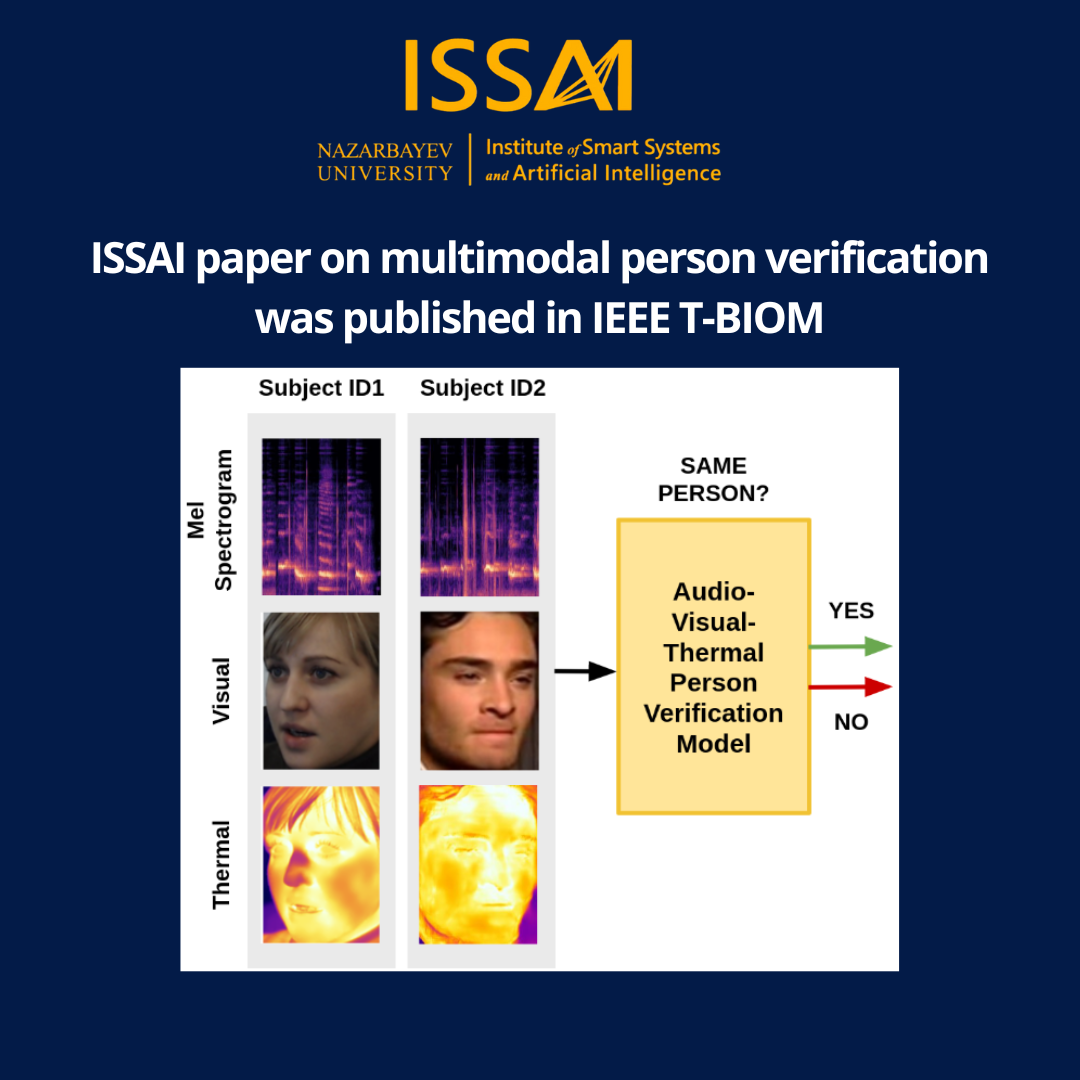

Исследователи ISSAI опубликовали революционную статью в престижном журнале «Транзакции IEEE по биометрии, поведению и идентификации личности». Авторы статьи аналитик данных Мадина Абдрахманова, исследователь Тимур Унаспеков, и директор ISSAI Атакан Варол рассматривают, как слияние аудио, визуальных и тепловых модальностей может быть использовано для улучшения производительности систем верификации личности.

Авторы использовали методы переноса области для дополнения своих обучающих данных, объединяя реальные аудио-визуальные данные из набора данных SpeakingFaces с синтетическими тепловыми данными из набора данных VoxCeleb. Команда исследователей обнаружила, что, используя оценочное слияние унимодальных аудио, унимодальных визуальных, бимодальных и тримодальных систем, обученных на объединенных данных, удалось достигнуть лучших результатов как на наборе данных SpeakingFaces, так и на VoxCeleb. Данный подход также продемонстрировал значительную устойчивость в сложных условиях, включая низкую освещенность и высокий уровень шума.

Ожидается, что публикация способствует дальнейшему исследованию использования синтетических данных, созданных генеративными методами, для улучшения производительности моделей глубокого обучения. Для поддержки и содействия исследованиям в области мультимодальной верификации личности команда ISSAI создала свой код, предварительно обученные модели и обработанный набор данных, со свободным доступом в репозитории GitHub.